La cruel guerra entre Rusia y Ucrania, los miles de víctimas, los desplazados, las ciudades y pueblos destruidos y la locura de unas armas cada vez más terribles que siguen masacrando a personas inocentes son a estas alturas una historia que se repite una y otra vez y la humanidad parece no querer aprender nunca de sus errores.

De todas las voces que se han alzado en nombre de la paz en los últimos tiempos, hay una, en particular, que parece preocuparse realmente por la propia paz, aunque sea más que por el gas, la venta de armas o las sanciones. Y estamos hablando del Papa Francisco.

De hecho, entre los distintos líderes mundiales, el Papa ha intentado, desde el inicio del conflicto, mantener abierto un canal diplomático con ambas partes, y lo ha hecho con gestos concretos: acudiendo personalmente a las embajadas rusa y ucraniana, activando las nunciaturas apostólicas presentes en ambos países, proporcionando ayuda material y apoyo espiritual, dialogando con los líderes políticos y religiosos (católicos y ortodoxos) de Rusia y Ucrania, incluido el primado del Patriarcado Ortodoxo de Moscú, Kirill, a quien, frente a los empujones cesaropapistas de éste para justificar la política agresiva de su país hacia Ucrania (especialmente en el famoso encuentro bilateral virtual entre el Papa y el citado patriarca), el pontífice (y recordemos aquí la etimología de ese término: constructor de puentes) no dejó de recordar que la tarea de los eclesiásticos es anunciar a Cristo, no favorecer u oponerse a un poder temporal, lo que fue reiterado, en el momento de escribir este artículo, el 6 de mayo de 2022, cuando Francisco, al recibir en audiencia a los participantes en la sesión plenaria del Consejo Pontificio para la Unidad de los Cristianos, condenó una vez más la guerra «cruel e insensata» en Ucrania, declarando que, «ante esta barbarie, renovamos nuestro deseo de unidad y anunciamos el Evangelio que desarma los corazones ante los ejércitos».

Sin embargo, no han faltado las críticas, tanto de católicos como de ortodoxos, al Papa por no adoptar una postura abiertamente pro-ucraniana en el actual conflicto.

La actitud de Francisco, sin embargo, está en perfecta continuidad, en este como en otros casos (la guerra de Siria o las más recientes protestas en Myanmar son ejemplos), con la de sus predecesores, en particular Juan Pablo II, al querer promover ciertos valores de paz, solidaridad y justicia social en todo el mundo, independientemente del país, la etnia o la religión. Por ello, dialoga y busca establecer relaciones con todos los gobiernos, independientemente de su credo o ideología, lo que se expresa también a través del concepto de multilateralismo, es decir, de la equidistancia (quizás, sin embargo, sería mejor decir equidistancia) con respecto a los sujetos implicados.

En la práctica, todo esto resulta extraordinariamente parecido a lo que ocurrió con Pío XII, el Papa reinante durante toda la Segunda Guerra Mundial, que nunca condenó abiertamente a Hitler, aunque, continuando la política de dura oposición a esa ideología de Pío XI (que condenó duramente el nazismo con la Encíclica «Mit brennender Sorge»), intervino varias veces contra la política nazi con diferentes mensajes, en particular con el mensaje de Navidad de 1942 y el consentimiento de la lectura de la famosa Carta Pastoral «Vivimos en un tiempo de grandes sufrimientos», redactada por la Conferencia Episcopal Holandesa y leída en todas las iglesias de Holanda el 26 de julio de 1942 (en represalia a la cual Hitler ordenó la detención y deportación de judíos conversos, hasta entonces librados de su furia, como Edith Stein, Santa Teresa Benedicta de la Cruz).

El tema es bastante complejo, pero igualmente interesante, ya que el papel de la Iglesia católica en los asuntos nacionales e internacionales es todo menos secundario, si pensamos que puede influir, directa e indirectamente, en miles de millones de personas, no sólo entre los bautizados, sino también entre sujetos jurídicos que pueden ser individuos, Estados, organismos supranacionales y que nada tienen que ver con la fe que profesan los católicos.

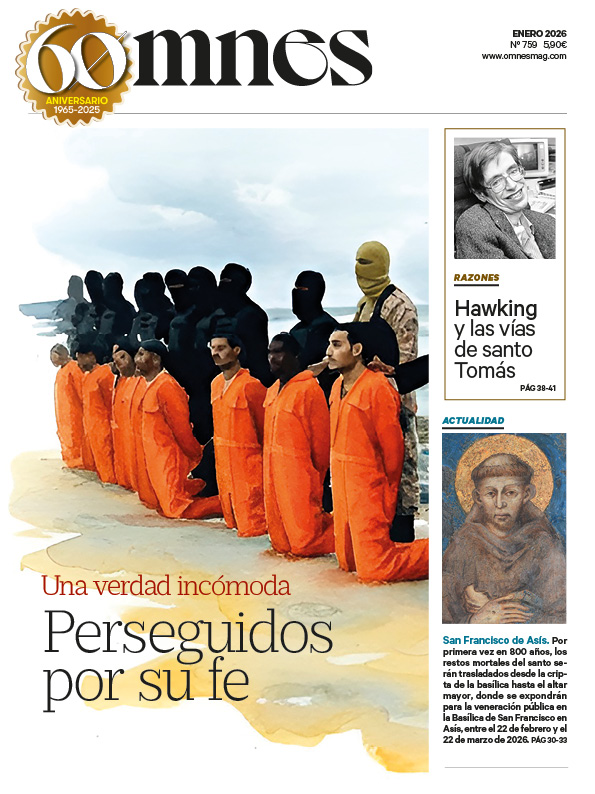

La necesidad de diplomacia y reconocimiento a nivel internacional

La diplomacia de la Santa Sede es heredera de una tradición milenaria, que ha hecho del papado el precursor de las relaciones modernas entre los Estados, y actúa en dos frentes particulares: por un lado, la protección de los cristianos, en particular de los católicos; por otro, la promoción de los valores de la justicia, la paz y la salvaguardia de los derechos humanos: su Ostpolitik, especialmente desde finales de los años 50, es un ejemplo concreto de ello.

Esta política realista, que toma su impulso de la encíclica «Pacem in Terris» del Papa Juan XXIII de 1963 (en la que el pontífice explica que la paz mundial es un ideal que debe perseguirse a través del diálogo y la cooperación con todos los pueblos «de buena voluntad», incluso con aquellos que son portadores de una ideología «errónea» como el ateísmo y el comunismo), que también condicionará la política internacional de la Santa Sede a partir de Pablo VI.

Es necesario, en este punto, hacer una distinción esencial entre la Santa Sede y el Estado de la Ciudad del Vaticano: la primera constituye una soberanía abstracta, es decir, sin un territorio bien definido, del Papa sobre los fieles católicos (unos mil 345 millones de personas, según el Annuarium Statisticum Ecclesiae de 2019), pero reconocida por todas las organizaciones internacionales; el segundo es, por otra parte, el Estado más pequeño del mundo (su superficie es de sólo 44 hectáreas), cuya única función es, en virtud de su creación en 1929 por los Pactos de Letrán, proporcionar apoyo material y jurídico a las actividades de la Santa Sede, incluida la salvaguardia de su patrimonio cultural, artístico y religioso.

La Santa Sede y la política internacional

La Sede Apostólica, por tanto, es la máxima autoridad de la Iglesia Católica y está regida por el Sumo Pontífice (el Papa) y la Curia Romana, encabezada por el Secretario de Estado, que, bajo la autoridad del Santo Padre, es el jefe de la estructura diplomática. Debido a su estatus especial, es la Santa Sede, y no el Estado de la Ciudad del Vaticano, la que mantiene relaciones diplomáticas con otros Estados y organismos internacionales, y estas relaciones requieren una gran organización institucional.

Los funcionarios de la diplomacia papal, así como los nuncios apostólicos y los laicos que representan al papado a nivel internacional, proceden de casi todos los Estados del mundo y se forman en la Pontificia Academia Eclesiástica, la escuela de política exterior del Vaticano.

El objetivo de los contactos con la sociedad civil es garantizar la supervivencia e independencia de la Iglesia y el ejercicio de su función específica (libertad de mantener el contacto con el centro; libertad de movimiento y responsabilidad de los obispos y sacerdotes; libertad de conciencia y de culto para todos). En ausencia de estas condiciones básicas, normalmente no se establecen relaciones diplomáticas (es el caso actual de China, Bután, Afganistán, Corea del Norte y las Maldivas).

La Santa Sede cuenta con una amplia y capilar red diplomática. De hecho, mantiene relaciones diplomáticas normales con 183 de los 193 Estados miembros de la ONU y tiene el estatus de observador permanente en las Naciones Unidas, pero no de miembro de pleno derecho, ya que es el representante de una potencia espiritual que opta por la neutralidad total en los asuntos internacionales.

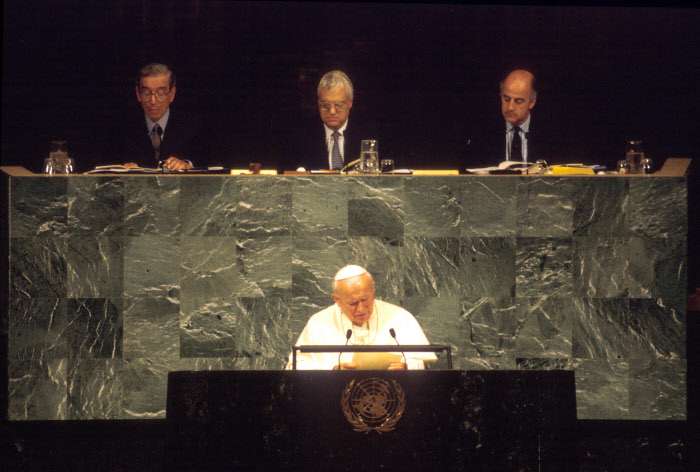

Juan Pablo II y su política internacional

La política internacional de Juan Pablo II es, por supuesto, la más obvia a tener en cuenta a la hora de analizar el concepto de multilateralismo de la Santa Sede en la política internacional, ya que el período de tiempo que abarca es notablemente amplio y confirma los múltiples y mencionados objetivos de la acción de la Santa Sede a nivel mundial. El pontificado de Juan Pablo II, de hecho, se caracterizó no sólo por su duración en términos de tiempo (27 años), sino también por el gran número de acontecimientos importantes que lo marcaron, por ejemplo, la larga disputa con los regímenes comunistas, en particular el de Polonia (su país de origen), el final de la Guerra Fría y la caída del Muro de Berlín, el reconocimiento de Israel y el establecimiento de relaciones diplomáticas con el Estado judío en 1994, los repetidos intentos de normalizar las relaciones con China y Vietnam, la desintegración de Yugoslavia, la histórica línea divisoria entre ortodoxos y católicos en los Balcanes, que puso en serios aprietos a la diplomacia vaticana y la llevó a intervenir directamente en el asunto en 1992, reconociendo la independencia de Croacia y Eslovenia, naciones tradicionalmente católicas.

Entre los casos más interesantes a mencionar, por su similitud con los temas actuales, está el de Filipinas, país que visitó Juan Pablo II en 1981 y donde la campaña de resistencia pasiva (muy similar a lo que ocurre hoy en Myanmar) liderada por el cardenal Jaime Sin contra Marcos tuvo como resultado el exilio del dictador en 1986; o Cuba, donde, en 1998, el Papa reiteró claramente su oposición al embargo y a las sanciones de Estados Unidos que asfixiaban la economía de la isla desde hacía 35 años, criticando esas medidas de represalia contra un país por parte de otros Estados y acusándolas, como en el caso de Irak o de Serbia (similar a la Rusia actual) de perjudicar sólo a ciudadanos inocentes sin aportar ninguna solución definitiva a los problemas.

Por último, quisiéramos mencionar dos casos particulares en los que, durante el pontificado de Juan Pablo II y a raíz de la intervención de Juan XXIII como mediador entre los Estados Unidos y la URSS en la crisis de los misiles de Cuba de 1962, la Santa Sede se mostró especialmente activa en la búsqueda de soluciones pacíficas a situaciones conflictivas en el ámbito internacional: En el primer caso, Wojtyla y sus representantes, en particular el Nuncio Apostólico en Argentina, lograron evitar el ya inminente conflicto entre Chile y Argentina por la soberanía del Canal de Beagle en 1984; en el segundo, durante la crisis internacional que precedió a la invasión de Irak en 2003, la diplomacia de la Santa Sede actuó en coordinación con los representantes de Francia, Alemania, Rusia, Bélgica y China en las Naciones Unidas para evitar el conflicto armado, y Juan Pablo II llegó incluso a enviar al Nuncio a Washington para que se reuniera con George Bush padre y le expresara el total desacuerdo del Papa con una invasión del país de Oriente Medio, que lamentablemente se produjo.

Todos estos ejemplos recuerdan notablemente a acontecimientos y cuestiones más recientes (Myanmar, Siria, la guerra entre Rusia y Ucrania y sus repercusiones) y permiten enmarcar la política internacional del Papa Francisco y su multilateralismo, o «equivocidad» con todas las partes implicadas en los conflictos a nivel internacional, como perfectamente adecuados a las necesidades de la diplomacia de la Santa Sede.

Escritor, historiador y experto en historia, política y cultura de Oriente Medio.